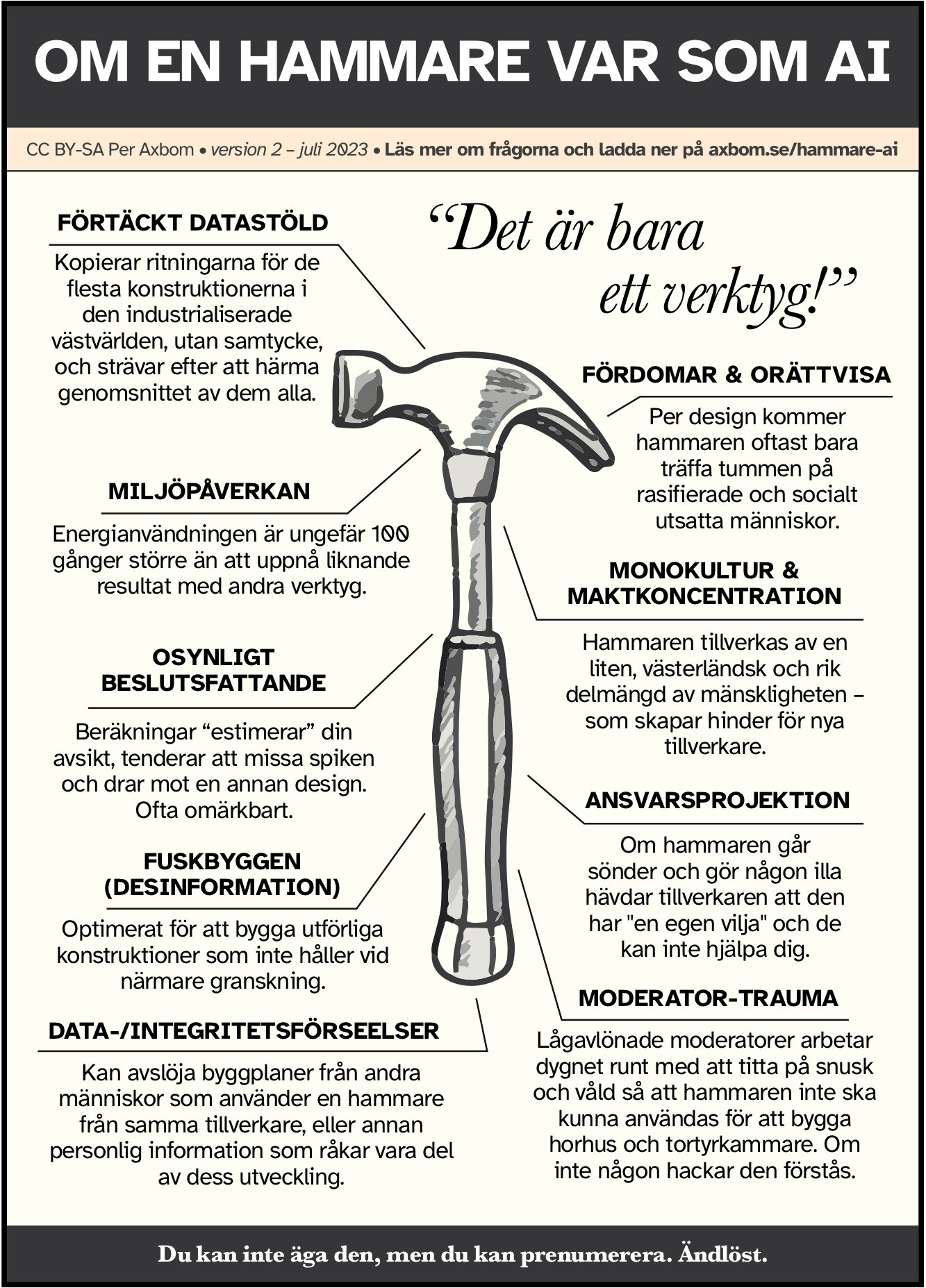

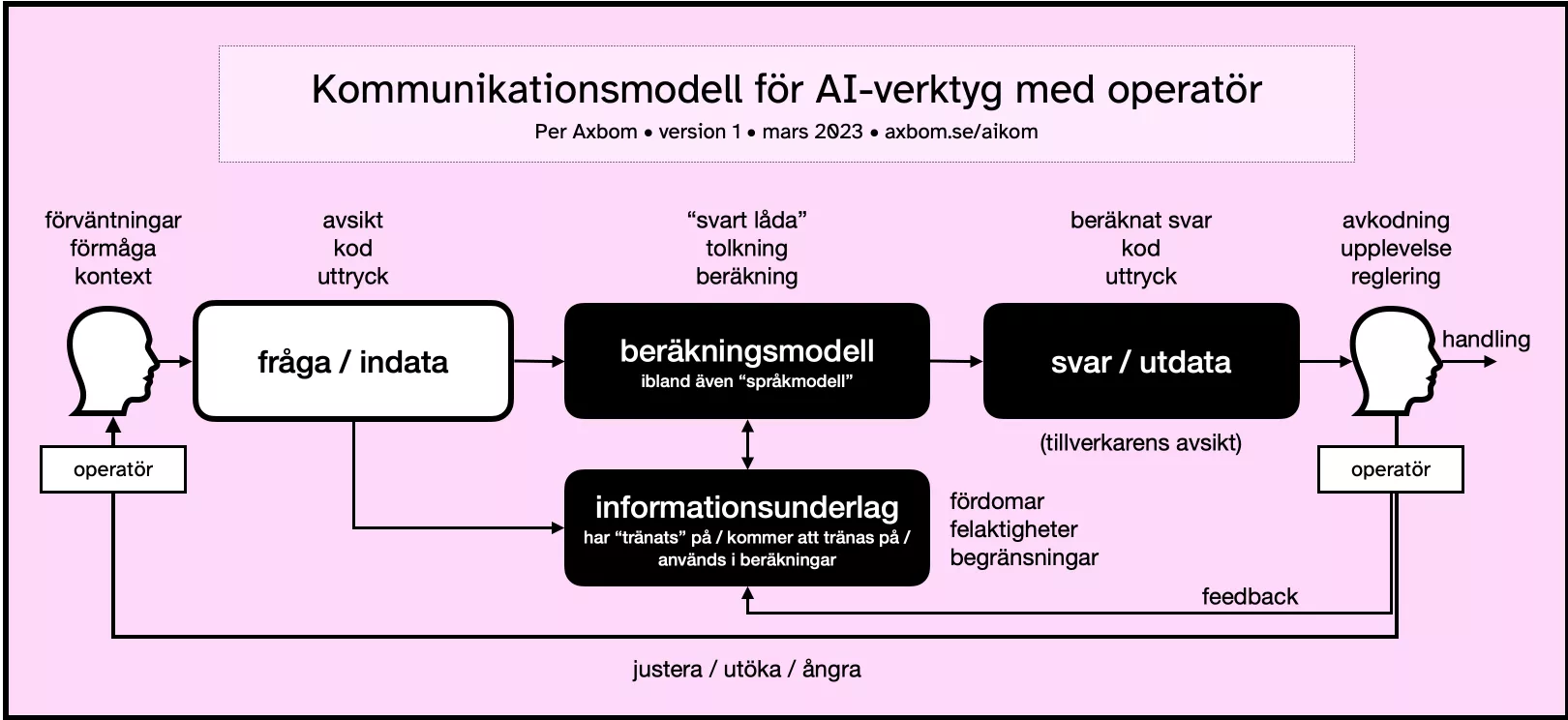

Om en hammare var som AI

Beräkningar “estimerar” din avsikt, tenderar att missa spiken och drar mot en annan design. Ofta omärkbart.

Ett vanligt argument jag stöter på när jag pratar om etik inom AI är att det bara är ett verktyg, och som vilket verktyg som helst kan det användas till gott eller ont. Ett bekant ställningstagande är detta: "Det är verkligen inget annat än en hammare". Jag kände mig manad att göra en affisch för att adressera dessa påståenden. Stjäl den, dela den, skriv ut den och använd den var du vill.

Lägg märke till att den här affischen i första hand tar upp egenskaperna hos generativ AI och djupinlärning, som är de mest framträdande teknikerna som uppmärksammas 2023.

För fler sätt som fördomar uppstår på inom maskininlärning, läs gärna mitt engelska inlägg Bias in Machine Learning. Jag har även samlat alla mina svenska inlägg om AI.

Beskrivning: Om en hammare var som AI

Det är bara ett verktyg!

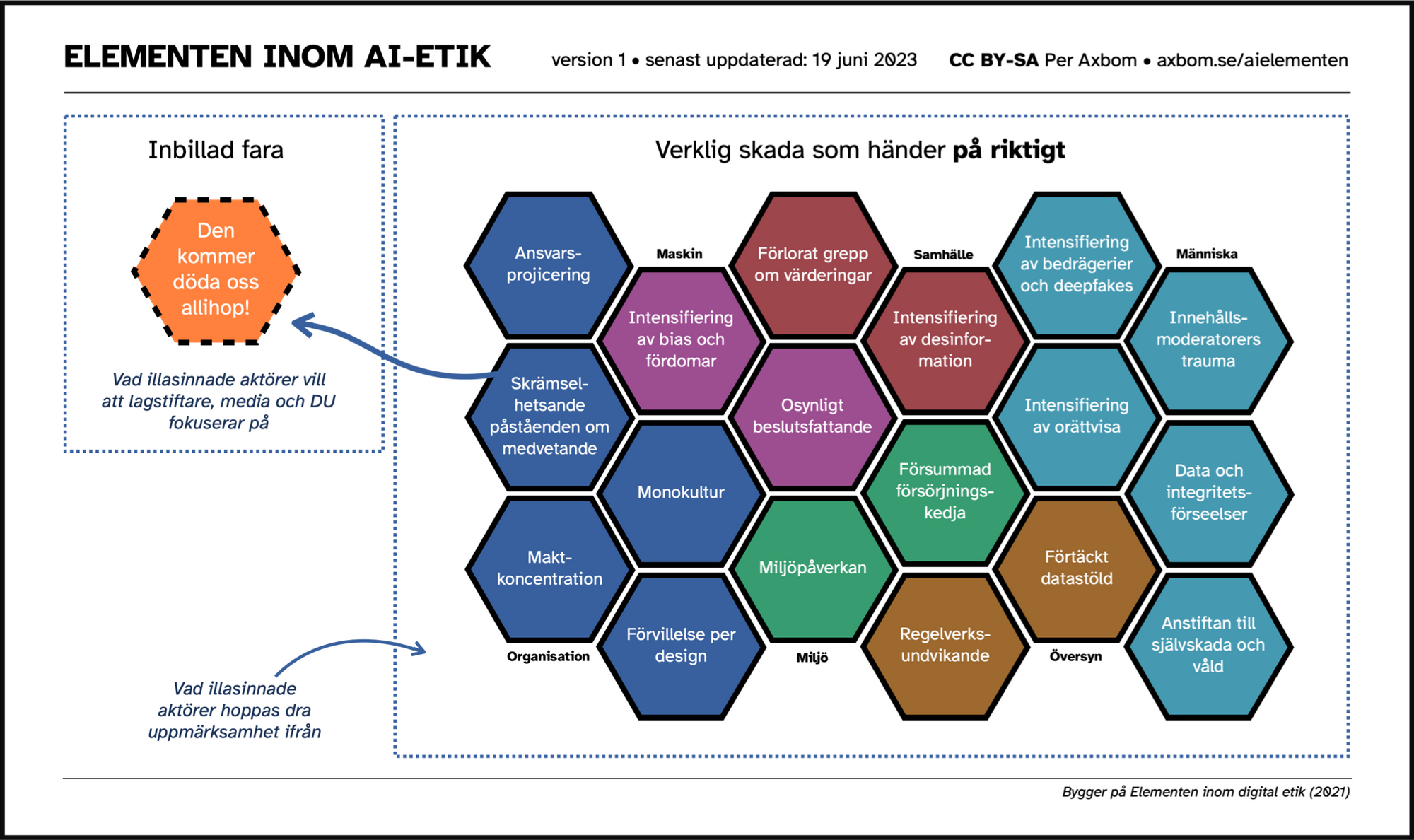

Nu när jag har din uppmärksamhet tar jag gärna tillfället i akt att bryta ner vart och ett av ämnesområdena som affischen hänvisar till. Dessa och många fler är även beskrivna i min infografik Elementen inom AI-etik.

Förtäckt datastöld

Kopierar ritningarna för de flesta konstruktionerna i den industrialiserade västvärlden, utan samtycke, och strävar efter att härma genomsnittet av dem alla.

För att bli så "bra" som de är i sin nuvarande form har många generativa AI-system tränats på enorma mängder data som inte var avsedda för detta ändamål och vars ägare och skapare inte har efterfrågats samtycke. Bara publiceringen av en artikel eller bild på webben innebär inte att den kan användas av vem som helst till vad som helst. Verktyg för generativ AI tycks komma undan med att ignorera upphovsrätt.

Samtidigt finns det många krångligheter som lagstiftare och beslutsfattare måste förstå för att kunna resonera på ett bra sätt kring intrång i rättigheter eller privilegier. Bilder är till exempel inte duplicerade och lagrade, de används för att mata en beräkningsmodell, vilket är ett argument som ofta används av försvarare för att förklara hur generativ AI bara "inspireras" av andras verk och inte "kopierar". Det finns flera pågående rättsfall som ifrågasätter denna uppfattning.

Fördomar och orättvisa

Per design kommer hammaren oftast bara träffa tummen på rasifierade och socialt utsatta människor.

En inneboende egenskap hos AI är dess förmåga att fungera som en accelerator för andra skador. Genom att tränas på stora mängder data (ofta utan tillsyn) som oundvikligen innehåller fördomar, övergivna värderingar och trångsynta kommentarer så kan dessa svagheter komma att reproduceras och förstärkas i utdata. Det är troligt att detta även kommer hända obemärkt (särskilt när det inte övervakas aktivt) eftersom många fördomar är subtila och inbäddade i vardagligt språk. Våra egna föreställningar och tankefel, så kallade bias, kan göra dem svåra att uppfatta. Och vid andra tillfällen kommer det att ske ganska tydligt, med botar som häver ur sig inskränkt, kvinnofientligt och rasistiskt innehåll.

På grund av systemproblem och det faktum att fördomar blir inbäddade i dessa verktyg, kommer dessa fördomar att få kännbara konsekvenser för människor som redan saknar makt. Poängsystem används ofta av automatiserade beslutsfattande verktyg och dessa poäng kan till exempel påverka jobbmöjligheter, behörighet till olika former av bidrag samt rättsliga utfall.

Nej, det här betyder inte att hammaren har egen vilja. Det betyder att hammaren konstruerats på ett sätt, med inbyggda fördomar, som har en tendens att missgynna människor som redan är diskriminerade och vars kraft att påverka har försvagats. AI-verktyg kan till exempel misslyckas med att minska fördomar inom rekrytering och bidra till rasistiska och sexistiska arbetsutvärderingar.

Det kan vara relevant att jämföra detta med beröringsfria tvålpumpar som inte reagerar på mörky hy. Det är inte användarens fel att den inte reagerar, det är tillverkarens fel, och hur den byggdes. Den "uppför" sig inte på det sättet för att den har en egen vilja, utan för att tillverknings- och designprocessen var försumlig. Du kan inte säga åt användaren att utbilda sig för att kunna använda den på ett bättre sätt. Läs också om Twitters algoritm för att beskära bilder, Googles oförmåga att hitta gorillor, webbkameror som inte märker av mörkhyade ansikten – säkert finns det många mer exempel som delats med mig genom åren.

Miljöpåverkan

Energianvändningen är ungefär 100 gånger större än att uppnå liknande resultat med andra verktyg.

Ja, det här är en avsiktligt provocerande siffra, eftersom OpenAI och andra tillverkare inte kommer att avslöja sina modellers energianvändning. Det finns uppskattningar som hävdar att en ChatGPT-fråga kostar (i pengar) 100 gånger mer än en Google-sökning, eller förbrukar 10 gånger så mycket energi. Och en ChatGPT-session, för att få det svar du vill ha, kan uppskattas till 10 sökkommandon, eller prompts.

Men å andra sidan finns det många exempel på saker som kan göras på mer miljövänliga sätt. Till exempel att skriva ett tal till ett bröllop. Året 2023 har verkligen blivit året då människor litar på en dator mer än sig själva för att skriva ord till sina nära och kära. Ett annat sätt att skriva ett tal till ett bröllop är penna och papper, och från hjärtat 😊.

Det vi trots allt vet är att energin som krävs för att hämta data, träna modellerna, driva modellerna och beräkna all interaktion med dessa verktyg är betydande. Med detta i åtanke är det lämpligt att fråga om varje utmaning verkligen letar efter en AI-lösning. Kanske kommer vi i framtiden se frasen "AI-drivet system" på samma sätt som "Diesel-driven SUV".

Monokultur och maktkoncentration

Hammaren tillverkas av en liten, västerländsk och rik delmängd av mänskligheten – som skapar hinder för nya tillverkare.

Idag finns det nästan 7 000 språk och dialekter i världen. Endast 7 procent återspeglas i publicerat onlinematerial. 98 procent av internets webbsidor publiceras på bara 12 språk, och mer än hälften av dem är på engelska. Även om en maskin skulle matas med innehåll från hela Internet är det fortfarande en liten del av mänskligheten.

76 procent av cyberbefolkningen bor i Afrika, Asien, Mellanöstern, Latinamerika och Karibien, medan det mesta av onlineinnehållet kommer från andra håll. Ta till exempel Wikipedia, där mer än 80 procent av artiklarna kommer från Europa och Nordamerika.

Fundera nu på vilket innehåll de flesta AI-verktyg tränas på.

Genom linsen av en liten del av mänsklig erfarenhet och omständigheter är det svårt att föreställa sig och förutse vidden av alla de perspektiv och öden som en ny skapelse kan påverka. Homogeniteten hos de som har antagit förmågan att bygga och skapa i det digitala rummet innebär att det främst är deras spegelbilder som gynnas – med bristande tanke på välbefinnande hos de som inte är synliga i den reflektionen.

När makt finns hos några få kommer deras egna behov och bekymmer på ett naturligt sätt placeras i första rummet och prioriteras. Ju mer deras behov prioriteras, desto mer makt får de och deras gelikar. Vem är med på dina möten? Vem saknas? Tre miljoner AI-ingenjörer är 0,0004 % av världens befolkning.

De dominerande aktörerna inom AI-området just nu är primärt USA-baserade. Och den datorkraft som krävs för att bygga och underhålla många av dessa verktyg är enorm, vilket säkerställer att makten över inflytandet kommer att fortsätta vila hos några få stora aktörer.

Osynligt beslutsfattande

Beräkningar “estimerar” din avsikt, tenderar att missa spiken och drar mot en annan design. Ofta omärkbart.

Ju mer komplexa algoritmerna blir, desto svårare är de att förstå. I takt med att fler är inblandade, tiden går, integrationer med andra system görs och dokumentationen är felaktig, desto längre undgår de mänsklig förståelse. Många företag kommer att dölja egen kod och undvika granskning, och ibland själva förlora hela bilden av hur koden fungerar. Man kommer inte kunna förklara hur eller varför vissa beslut tas. Att avkoda och förstå hur beslut fattas kommer därmed att vara öppet för oändligt färre personer.

Och det stannar inte där. Detta påverkar också människors autonomi. Genom att dölja beslutsprocesser (hur, när, varför beslut fattas, vilka alternativ som finns tillgängliga och vilka personuppgifter som delas) är det allt svårare för individer att göra väl underbyggda val för sitt eget bästa.

Ansvarsprojicering

Om hammaren går sönder och gör någon illa hävdar tillverkaren att den har "en egen vilja" och de kan inte hjälpa dig.

Jag är förtjust i termen "Moral outsourcing" som myntats av Dr Rumman Chowdhury. Det relaterar till hur tillverkare av AI lyckas skjuta över moraliskt beslutsfattande till maskiner, som om de själva inte har något att säga till om.

Genom användning ordet ansvar vill jag betona att organisationer har en tendens att inte bara undandra sig moraliska överväganden utan också det konkreta ansvar som måste åtfölja tillverkningen av produkter och tjänster. Projicering är lånat från psykologin och åsyftar hur tillverkare, och de som implementerar AI, vill bli rentvådda och projicerar sin egna svagheter på något annat – i det här fallet själva verktyget.

Inramningen av AI tycks ge tillverkare och produktägare ett "Slipp-ur-fängelse kort" genom att skylla på den maskin de har skapat, som om de inte har någon kontroll över vad de gör. Föreställ dig att du köper en tvättmaskin som krymper alla dina kläder, och att tillverkaren kan undvika allt ansvar genom att hävda att tvättmaskinen har ett "eget sinne".

Maskiner är inte oetiska, men tillverkarna av maskiner kan agera oetiskt.

Fuskbyggen (desinformation)

Optimerat för att bygga utförliga konstruktioner som inte håller vid närmare granskning.

Den skada som nästan alla verkar vara överens om är det överflöd av desinformation som många av dessa verktyg kommer att tillåta nästan utan kostnad för illasinnade aktörer. Det händer förstås redan. Det finns både den typ av desinformation som trollfabriker nu med glädje kan generera i mängder med perfekt grammatik på många språk, och även den typ av desinformation som sprider sig med den dagliga användningen av dessa verktyg, och ofta omedvetet.

Den senare typen av desinformation genereras och sprids även av högutbildade och yrkesverksamma inom respekterade offentliga verksamheter. Verktygen är redan så förvillande bra på att framstå som självsäkra när de uttrycker nonsens i ett trovärdigt, blomstrande och förföriskt språk.

En oro som nu dyker upp och som fortfarande söker svar är vad som kommer att hända när verktygen börjar "tränas" med de texter som de själva har genererat.

Data-/integritetsförseelser

Kan avslöja byggplaner från andra människor som använder en hammare från samma tillverkare, eller annan personlig information som råkar vara del av dess utveckling.

Det finns flera sätt för personlig data att ta sig in i AI-verktygen.

För det första, eftersom verktygen ofta tränas på data tillgänglig online och på ett oövervakat sätt, kommer personuppgifter ta sig in i verktygen när de utvecklas. Data kan oavsiktligt ha publicerats online eller kan ha publicerats för ett specifikt syfte. Och då sällan ett syfte som innebär matning av ett AI-system och dess uppsjö av utdata.

För det andra, personliga uppgifter matas in i verktygen av vanliga användare genom vårdslös eller hänsynslös användning – data som ibland också lagras och används av verktygen.

För det tredje, när många datapunkter från många olika källor länkas samman i ett verktyg kan de avslöja detaljer om en individs liv som någon enskild information eller datapunkt – till synes harmlös – inte kan.

Moderator-trauma

Lågavlönade moderatorer arbetar dygnet runt med att titta på snusk och våld så att hammaren inte ska kunna användas för att bygga horhus och totryrkammare. Om inte någon hackar den förstås.

För att vi ska undvika att se traumatiserande innehåll när vi använder många av dessa verktyg (som fysiskt våld, självskada, barnmisshandel, mord och tortyr) måste detta innehåll filtreras bort. För att det ska filtreras bort måste någon titta på det. De arbetare som utför denna filtrering exploateras ofta och lider av posttraumatiskt stressyndrom utan adekvat vård för att hantera sitt lidande. Många av dem har ingen aning om vad de ger sig in på när de tar jobbet.

Du kan inte äga den, men du kan prenumerera. Ändlöst.

Men är inte AI ett verktyg?

Ja, det är rimligt att påpeka att AI i sina många olika former av mjukvara kan betraktas som ett verktyg. Men det är inte syftet med uttalandet. Ordet att vara vaksam på är "bara". Om någon skulle säga "det är ett verktyg", så är det befogat. Men ordet "bara" läggs till för att avfärda ansvar.

Därför är min oro att uttalandet i sig överskyler ansvarstagande och försvagar hänsynstagande till vidare effekter. Att säga att något bara är ett verktyg skapar den felaktiga mentala bilden av att alla verktyg har utbytbara egenskaper ur ett etiskt perspektiv, vilket helt enkelt inte är sant.

Det här inlägget, och affischen, finns även på engelska.

"Inte all AI!"

Ja, det här är en gäcksam affisch och du vill förmodligen ha mer insikter om bakgrunden till de ämnen jag tar upp. Du kan få lite av den bakgrunden i mitt diagram Elementen inom AI-etik:

Läs också

Kommentera